从经典到量子:计算技术的深刻变革与挑战

随着计算机科学和物理学的不断进步,计算技术正经历着一场前所未有的革命。从经典的冯·诺依曼架构到量子计算,这一转变不仅标志着计算能力的巨大飞跃,也带来了全新的计算范式。本文将深入探讨这一变革过程中的关键概念、技术挑战以及未来可能的发展方向。

一、经典计算与量子计算的基本原理

经典计算机基于二进制系统,使用位(bit)作为基本单位,每个位可以表示为0或1。通过一系列逻辑门操作,经典计算机能够执行复杂的计算任务。随着问题规模的增长,经典计算机面临“计算瓶颈”的困境。例如,在处理大规模数据集或解决某些NP难题时,经典计算机所需的计算时间和资源呈指数级增长。

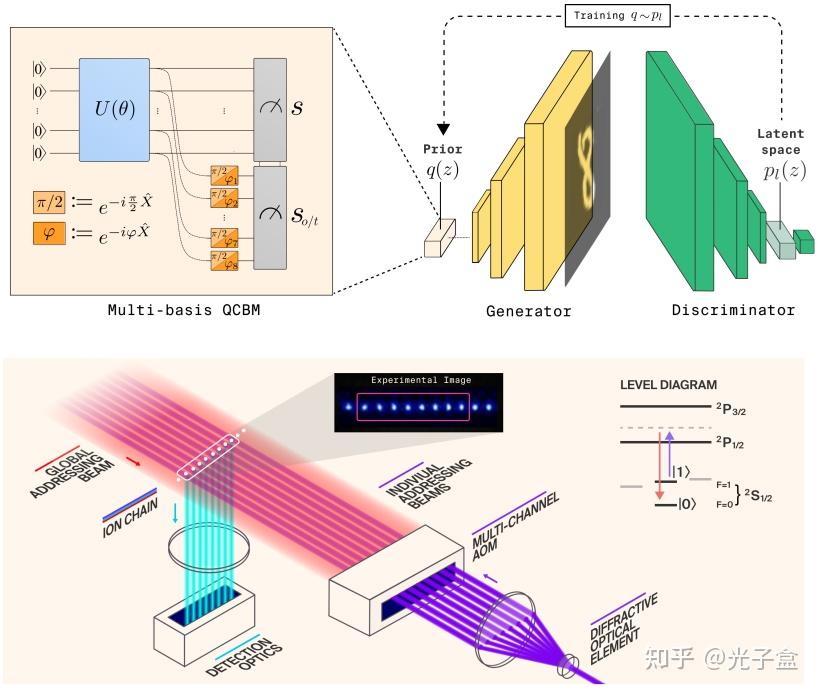

相比之下,量子计算机利用量子力学的独特性质来实现计算。量子比特(qubit)是量子计算机的基本单元,它可以同时处于多个状态(即叠加态),并且两个量子比特之间可以通过纠缠态建立非局域的相关性。这些特性使得量子计算机在理论上具备解决经典计算机难以处理的问题的能力。

二、经典计算向量子计算的过渡

从经典计算到量子计算并非一蹴而就的过程,而是经历了漫长的研究和发展阶段。早期的研究主要集中在理解量子力学的基本原理及其在计算领域的应用潜力。20世纪80年代末至90年代初,科学家们开始探索如何构建实用的量子计算机,并提出了多种量子算法,如Shor算法(用于分解大整数)、Grover算法(用于无序数据库搜索)等。

近年来,随着实验技术的进步,研究人员成功地制造出了小型量子计算机原型,并实现了多项重要成果。例如,谷歌于2019年宣布其量子计算机“Sycamore”在特定任务上达到了“量子优越性”,即它能够在合理的时间内完成经典计算机无法在相同时间内完成的任务。这标志着量子计算领域迈出了重要的一步。

发表评论